Ein immer wieder geäußerter Verdacht besagt, dass man umso mehr positive Fälle bekommt, je mehr man mehr testet. Das klingt zunächst einleuchtend, ist aber nicht korrekt.

Modellierung

Zur Modellierung beziehe ich mich auf ein paar wohl fundierte Voraussetzungen:

- Es gibt eine reale Inzidenz, d.h. ein bestimmter Prozentsatz der Bevölkerung ist aktuell infiziert.

- Betrachtet wird ein Schnappschuss des Infektionsgeschehens, weitere Ansteckungen während dieser Zeit bleiben außen vor.

- 20% der Infizierten hat Symptome.

- Jeder Infizierte hat 3,2 weitere Menschen angesteckt.

- 40% der Menschen, die Symptome haben, sind tatsächlich infiziert.

- 5% der nachverfolgten Kontakte sind infiziert.

- Der Test wirkt zu 100%, er erkennt eine Infektion zweifelsfrei.

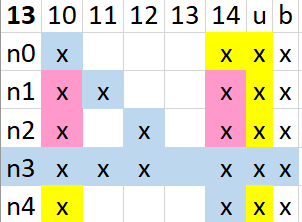

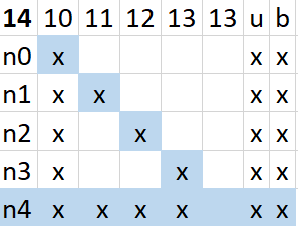

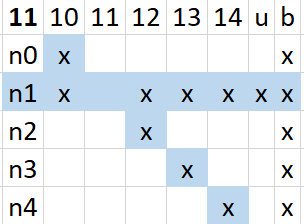

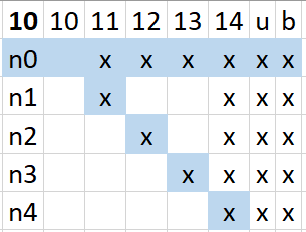

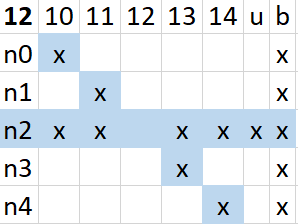

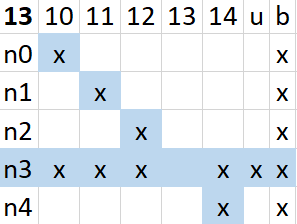

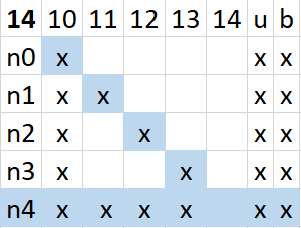

Dies bedeutet, dass es einen unentdeckten Rest an Infektionen gibt, der nicht zu den 20% Symptomatischen oder den 64% angesteckten Kontakten gehört. 16% sind also ohne erkennbaren Bezug infiziert. In diesem Modell nehme ich eine Stadt mit 100000 Einwohnern, so dass die Anzahl der positiven Tests und die Inzidenzzahlen identisch sind. So setzen sich 1% Infizierte somit aus 200 Symptomatischen, 640 infizierten Kontakten und 160 unentdeckten Fällen zusammen. Insgesamt ist das eine reale Inzidenz von 1000.

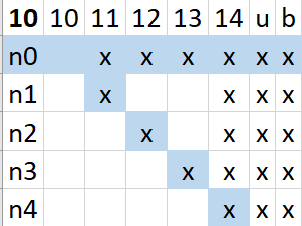

Das Testregime geht strikt vor:

- Zuerst werden symptomatische Personen getestet.

- Sind noch Kapazitäten frei, so werden Kontaktpersonen getestet.

- Sind dann noch Kapazitäten frei, so werden weitere Personen getestet.

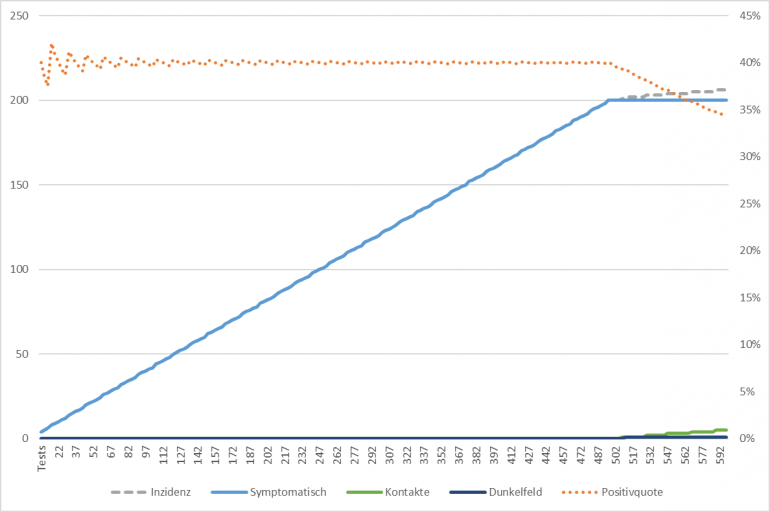

Beginnt man mit wenigen Tests, so reicht die Testkapazität nicht aus, alle symptomatischen Personen zu testen. Aber nicht alle Tests sind auch positiv.

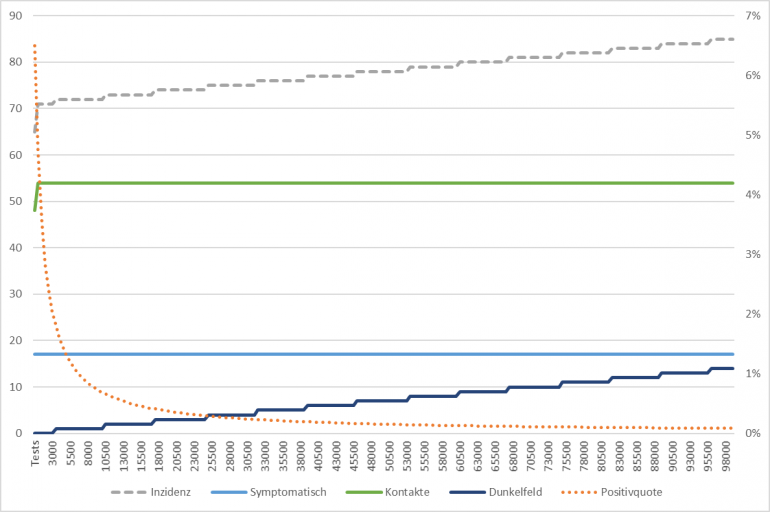

Die Anzahl der entdeckten Fälle steigt also linear mit der Anzahl der Tests an, wobei die Positivquote sich bei 40% einpegelt. Das ist genau der Wert, der für den Anteil der Infizierten unter den Symptomatischen vorgegeben war.

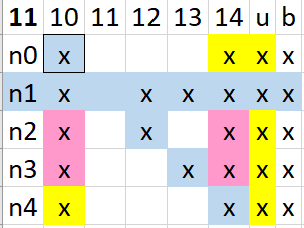

Erst, wenn alle 500 symptomatischen Personen auch getestet wurden, um die 200 (40%) Infizierten zu finden, kommen die Kontaktpersonen an die Reihe und die Positivquote sinkt. Man erreicht einen Inzidenzwert von 200, der um den Faktor 5 zu niedrig ist. Ja, das ist genau die gern bemühte Dunkelziffer vom Frühjahr 2020.

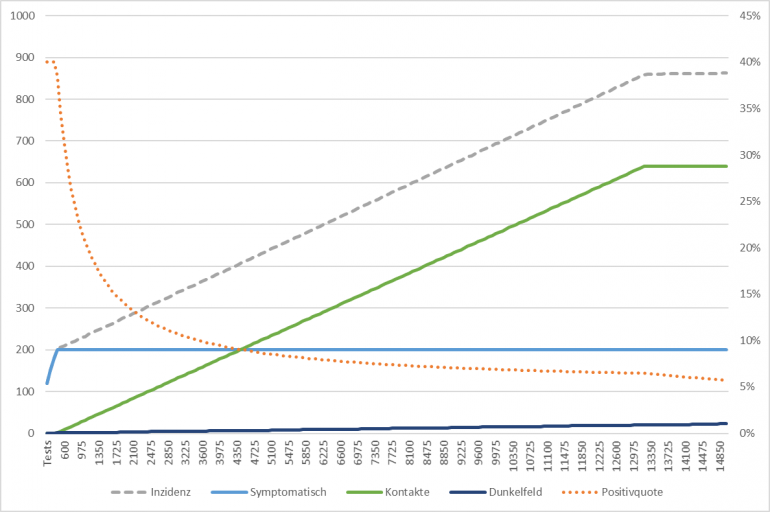

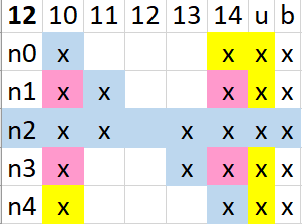

Auch jetzt muss wieder viel getestet werden, um alle Kontaktpersonen zu überprüfen. Wiederum steigt die Inzidenz mit den Tests linear an, diesmal aber langsamer, denn man liegt oft (zu 95%) falsch. Dabei werden aber schon die ersten Fälle entdeckt, die nichts mit den ursprünglichen Ansteckungsverhältnissen zu tun haben.

Hat man alle Kontaktpersonen durch stabilisiert sich die Inzidenz bei 840 (von real 1000). Die Positivquote ist inzwischen auf ca 7% gefallen. Die Dunkelziffer beträgt nach der Ausleuchtung der Kontakte nur noch bei 1,2. Man ist also schon ziemlich nahe dran.

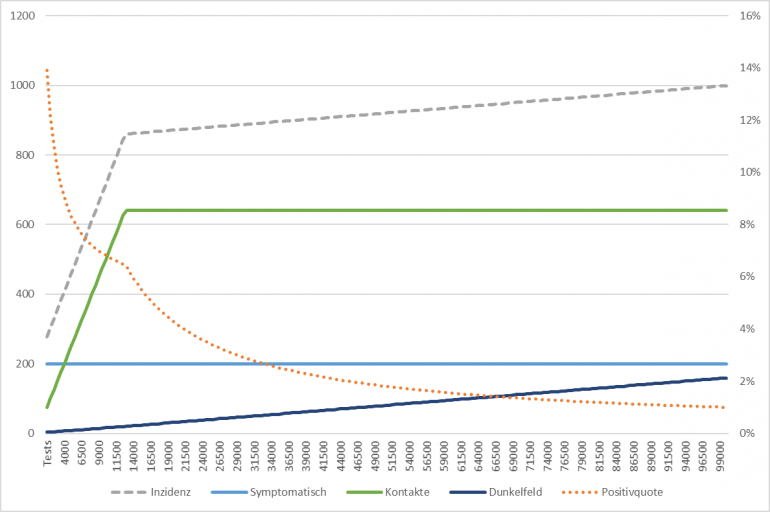

Weitere Tests hellen das Dunkelfeld immer weiter auf, die Positivqoute sinkt weiter, bis sie die realen 1% der Infektionsrate erreicht hat.

Fazit

Die Erhöhung der Tests führt zu erhöhten Inzidenzzahlen, indem die noch unentdeckten Fälle aufgedeckt werden. Die Anzahl der positiven Tests überschreitet dabei niemals die realen Fälle, es wird nur das Maß der Unbestimmtheit verringert.

Das geschieht in drei Stufen: Nach der Aufdeckung der symptomatischen Fälle kommt es zur ersten Stagnation, eine Erhöhung der Tests führt nicht mehr im gleichen Maße zu einer Erhöhung der positiven Fälle. Die Positivquote sinkt.

Nach der Aufdeckung der Kontakte kommt es zu einer weiteren Stagnation, eine Erhöhung der Tests führt nicht mehr im gleichen Maße zu einer Erhöhung der positiven Fälle. Die Positivquote sinkt weiter. Dabei ist schon fast das ganze Infektionsgeschehen sichtbar. Es sind dafür fast 10% der Bevölkerung zu testen.

Die restlichen 90% der Bevölkerung zu testen, führt zur Aufdeckung der restlichen 16% der Fälle und damit zum Erliegen der Ausbreitung. Bis zur nächsten Einschleppung.

Es ist nicht möglich, durch mehr Tests beliebig hohe Inzidenzen zu erreichen. Man kann eine Pandemie nicht herbei testen!

Ein realistischeres Beispiel

Ganz offensichtlich sind 1% Infektion in der Bevölkerung extrem viel. Dies würde bedeuten, dass in Folge dieses Geschehens ca. 20 Personen versterben (2% Tödlichkeit). Eine Inzidenz von 1000 ist weit mehr, als wir hier real erleben und hoffentlich auch nicht erleben müssen.

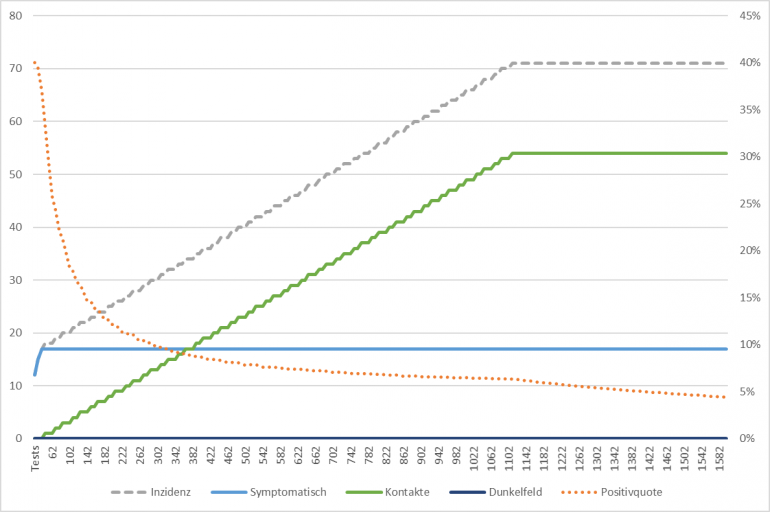

In Jena (ca. 100000 Einwohner) werden ca. 70 Leute in einer Woche positiv getestet. Dies entspricht in dem Modell einem Schnappschuss, weil es etwa der Zeit der Kontaktnachverfolgung entspricht. Die Positivquote ist ca, 5% (Durchschnitt in Deutschland). Damit wurden 1400 Tests durchgeführt.

Durch Ausprobieren komme ich damit auf eine realen Infektionsrate von 0,085%, d.h. 85 Infizierte (17 mit Symptomen, 54 in den Kontakten und 14 sonstige). Davon werden bei 1400 Tests alle Symptomatische und alle Kontakte gefunden, jedoch kein weiterer Fall. Die beobachtete Inzidenz liegt somit bei 71. Real wären es 85.

Steigert man die Zahl der Tests, so findet man erst bei ca. 4000 Tests den nächsten, bis dahin völlig unbekannten Fall. Man kann auch bis 1200 Tests zurück gehen, ohne einen Fall zu übersehen. Die Anzahl der Tests spielt also keine Rolle mehr für die ermittelte Inzidenz. Nur die Positivquote wandert von 2% zu 6%. Dazu sind nur etwas mehr als 1% der Bevölkerung zu testen.

Mit den 1400 Tests bei einer Inzidenz von 70 liegt Jena also nur knapp über der Schwelle, die notwendig ist, um das Kontaktumfeld auszuleuchten.

Zum Abschluss nochmal das volle Bild für diesen Fall: Jena, gemessene Inzidenz 70 bei 5% Positivquote, reale Inzidenz 85 (= 0,085% Infizierte)

Eine Inzidenz von 70 bedeutet aber auch, dass es in den nächsten drei bis sechs Wochen ein bis zwei weitere Todesfälle geben wird, die auf genau diese Woche zurück gehen. Noch mehr Personen werden nach schwerem Verlauf lange Schäden davon tragen. Und dann kommt schon wieder die nächste Woche.

Zu kompliziert? Dann vielleicht mal die andere Erklärung lesen.